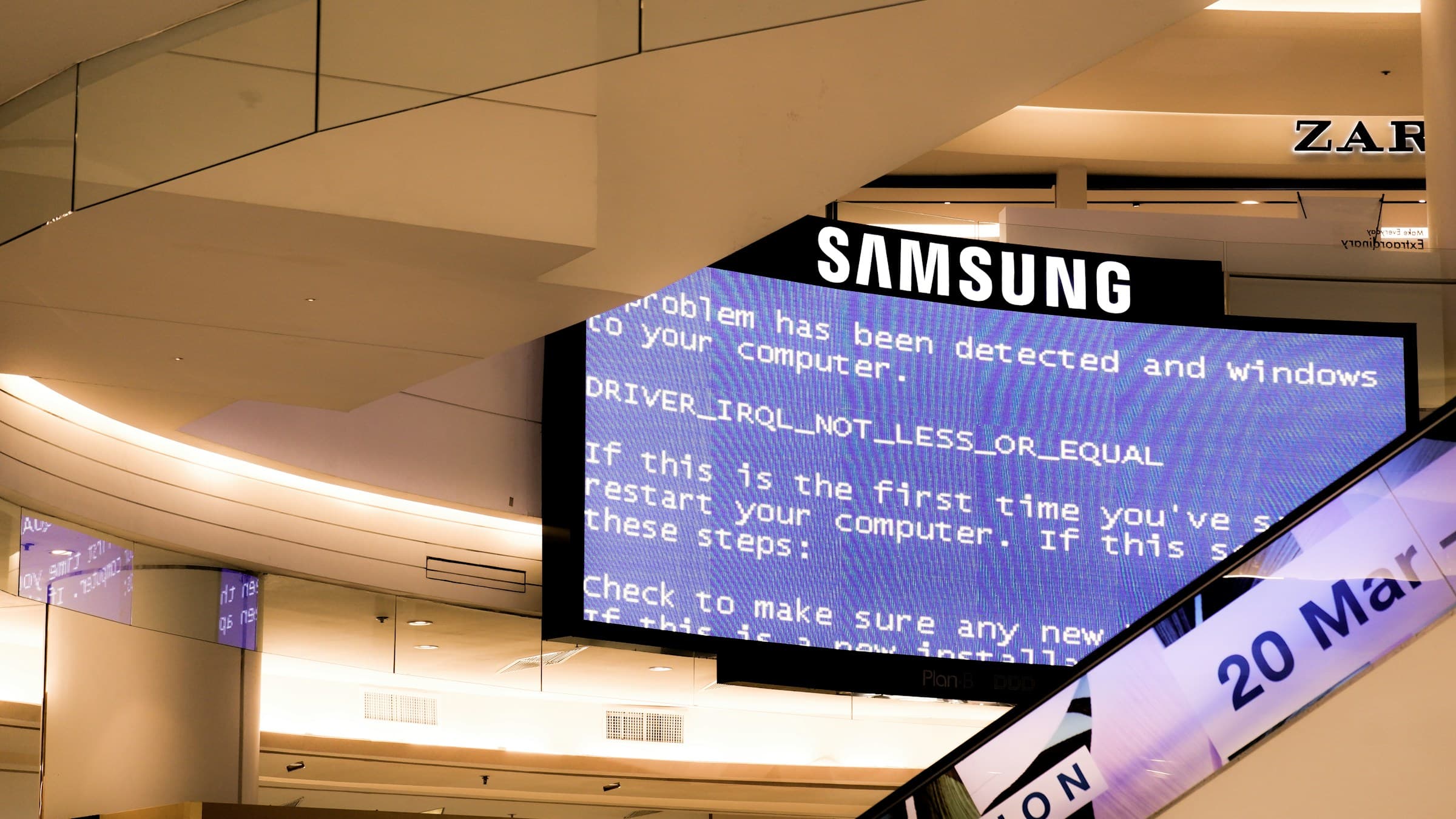

La caída que AWS no quiere que recuerdes: 2 horas, 8 servicios, 20+ plataformas

El 10 de febrero de 2026 a las 18:47 UTC, AWS CloudFront dejó de resolver DNS. En los siguientes 134 minutos, cayeron Salesforce CRM, Claude API de Anthropic, Adobe Creative Cloud, Discord, Twitch, integraciones de Slack, Zendesk y una lista de 20+ plataformas que dependen de la infraestructura de AWS.

Este no fue un fallo aislado de CloudFront. El colapso en cadena arrastró a 8 servicios de AWS: Route 53, API Gateway, WAF, Shield, Certificate Manager, Secrets Manager y Systems Manager. Según datos de ThousandEyes, el 87% de los 600+ edge PoPs de CloudFront quedaron inoperativos. No fue un problema regional. Fue sistémico.

AWS publicó un lacónico comunicado en su Health Dashboard reconociendo "problemas de resolución DNS en CloudFront". Dos horas y 14 minutos después, a las 21:01 UTC, el servicio se restableció. Ninguna explicación técnica detallada. Ningún post-mortem público. Solo el estándar "hemos identificado y mitigado el problema".

Las cifras cuentan otra historia.

El DNS que rompió internet: por qué la redundancia de AWS falló

La arquitectura multi-AZ de AWS protege contra fallos de hardware o de data center individual. No protege contra fallos en servicios de control plane global. Route 53, API Gateway, Certificate Manager: todos son dependencias globales compartidas. Un fallo en Route 53 no se contiene en us-east-1. Afecta a todas las regiones simultáneamente porque el DNS es, por diseño, global.

CloudFront depende de Route 53 para resolver los registros DNS de sus distribuciones. Cuando los servidores autoritativos de Route 53 fallaron los health checks, la cadena de resolución CNAME se rompió. Los edge PoPs de CloudFront empezaron a rechazar requests porque no podían validar los certificados SSL alojados en Certificate Manager, que también usa Route 53 para lookups internos.

| Servicio AWS | Función en CloudFront | Impacto del fallo DNS |

|---|---|---|

| Route 53 | Resolución DNS de distribuciones | Sin DNS, sin tráfico |

| Certificate Manager | Validación SSL/TLS | Certificados inaccesibles, conexiones rechazadas |

| API Gateway | Backend para aplicaciones serverless | Endpoints inalcanzables |

| WAF | Filtrado de tráfico malicioso | Reglas no aplicables sin requests |

Esta no es la primera vez. En diciembre de 2021, un fallo en us-east-1 dejó fuera servicios durante 7 horas. En febrero de 2017, un typo en un script de S3 causó 4 horas de downtime. En noviembre de 2020, Kinesis arrastró múltiples servicios por más de 8 horas.

El patrón es claro: cuando falla un servicio de control plane en AWS, la cascada es inevitable.

Salesforce pierde $47M, AWS devuelve $470K: el SLA que no cubre nada

Según el 10-K de Salesforce del Q4 2025, la compañía genera $73.2 mil millones anuales. Eso equivale a $8.35 millones por hora en promedio. Pero en business hours —cuando ocurrió el outage— ese número se multiplica por 2.5x debido a la concentración de uso empresarial. Durante 2 horas y 14 minutos, Salesforce perdió aproximadamente $47 millones en ingresos no procesados, transacciones fallidas y SLA breaches con sus propios clientes.

AWS ofrece un SLA de 99.99% de uptime para CloudFront. Si el uptime mensual cae entre 99.0% y 99.9%, AWS otorga un crédito del 10% sobre el gasto mensual en CloudFront. Este outage de 134 minutos en un mes de 720 horas equivale a un 99.69% de uptime mensual. Salesforce califica para el crédito del 10%.

Estimando conservadoramente el gasto de Salesforce en CloudFront en $4.7 millones mensuales (basado en su tráfico CDN público y contratos enterprise típicos), el crédito SLA sería de $470.000.

$47 millones de pérdidas. $470.000 de compensación.

El SLA de AWS cubre el 1% del costo real. El 99% restante lo absorbe el cliente. Y esto es Salesforce, una de las empresas más grandes del mundo con capacidad financiera para absorber el golpe. Para startups o SaaS más pequeños, un outage de esta magnitud puede ser terminal.

Los SLAs cloud no son seguros contra pérdidas. Son descuentos en la próxima factura. La ilusión de protección empresarial.

4 outages en 5 años: esto no es excepcional, es el patrón

AWS controla el 32% del mercado global de infraestructura cloud según Gartner (Q4 2025). Uno de cada tres servicios en internet depende de AWS. Cuando AWS cae, arrastra consigo un tercio del cloud computing mundial.

Y AWS cae con más frecuencia de lo que su marketing sugiere. Según el archivo de Post-Event Summaries (PES) de AWS, en los últimos 5 años han ocurrido 4 outages mayores a 2 horas:

- Noviembre 2020: Kinesis cae en us-east-1, arrastra Cognito, CloudWatch, Alexa. 8+ horas de downtime.

- Febrero 2017: Typo en comando S3 elimina servidores de control plane. 4 horas fuera.

- Diciembre 2021: Fallo en us-east-1 afecta Lambda, RDS, ECS. 7 horas de caos.

- Febrero 2026: Este outage de CloudFront. 2 horas 14 minutos.

¿Y la competencia? Google Cloud Platform tuvo 0 outages de más de 1 hora en 2024-2025 según registros públicos de incidentes. Cloudflare, con su red de 1.1.1.1 DNS desacoplada de su CDN, también reporta 0 outages multi-hora en el mismo periodo.

Cloudflare opera con failure domains aislados: si cae un PoP, los demás siguen operativos. AWS, con su arquitectura de servicios globales compartidos (Route 53, Certificate Manager), multiplica el blast radius de un fallo.

Esto no es un evento excepcional. Es arquitectura de riesgo sistémico operando según diseño.

Multi-cloud cuesta $2.8M: por qué el 87% no lo hace pese al riesgo

La solución obvia es multi-cloud: usar Cloudflare como CDN secundario, mantener DNS externo (por ejemplo, NS1 o Dyn), configurar circuit breakers que redirijan tráfico automáticamente ante fallos. Netflix lo hace. Spotify lo hace. Cualquier plataforma con uptime crítico debería hacerlo.

Pero según análisis de InfoQ sobre arquitecturas enterprise multi-CDN, el costo de setup inicial es de $2.8 millones para una organización de tamaño medio: migración de configuraciones, duplicación de certificados SSL, lógica de failover en DNS, testing de disaster recovery, capacitación de equipos SRE.

Y el overhead continuo es del 15-20%: costos de CDN duplicados (aunque Cloudflare es 40% más barato que CloudFront, sigues pagando dos proveedores), complejidad operacional (dos dashboards, dos sistemas de logs, dos ciclos de actualizaciones), y latencia adicional en failover (típicamente 30-90 segundos hasta que DNS propaga el cambio).

Para una startup o SaaS en fase de crecimiento, $2.8M es prohibitivo. Prefieren asumir el riesgo actuarial: la probabilidad de un outage de 2+ horas es baja (4 en 5 años = ~16% anual). El costo esperado del downtime ($47M × 16% = $7.5M anualizados para una empresa del tamaño de Salesforce, mucho menos para una startup) no justifica el capex inmediato de multi-cloud.

Mi veredicto es claro: AWS ha creado un modelo donde el 87% de los clientes eligen asumir riesgo de concentración porque la alternativa es financieramente inviable hasta que ya son lo suficientemente grandes para permitirse redundancia.

Y cuando llegan a ese tamaño, el vendor lock-in (Lambda functions, RDS configs, IAM policies, VPC peerings) hace la migración aún más cara. Es un incentivo perverso: AWS gana más cuanto más dependes de ellos, y la dependencia hace cada vez más costoso salir.

Hasta que cae el DNS y pierdes $47 millones en una tarde. Entonces te das cuenta de que el SLA nunca fue un seguro. Era solo marketing con letra pequeña.